30 OCT | 19:23

Crean una IA que revoluciona el lenguaje de señas en el mundo

Todos lo entenderemos. En la actualidad, esta desarrolladora de software trabaja en Microsoft. Una joven en India desarrolló una inteligencia artificial capaz de interpretar el lenguaje de señas en inglés. Por Isabela Durán San Juan

Priyanjali Gupta, quien estudiaba una licenciatura en tecnología en el Instituto de Tecnología de Vellore, creó este programa durante su carrera. Actualmente, trabaja como desarrolladora de software en Microsoft, según su perfil de LinkedIn.

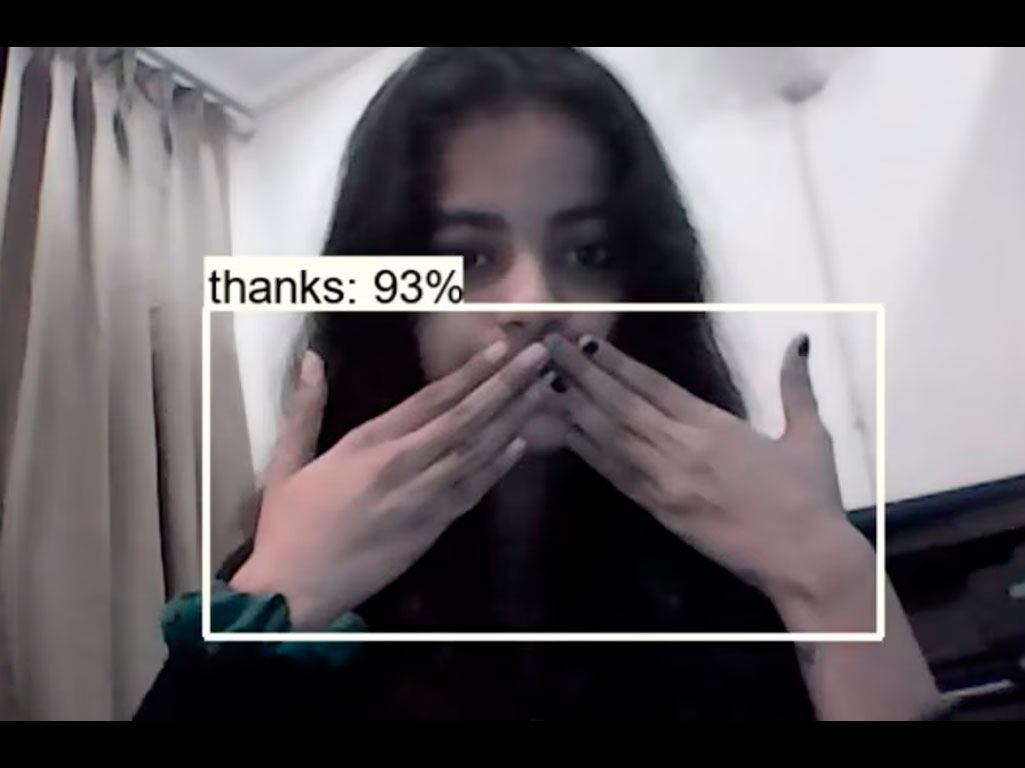

Fue precisamente en esta red social donde Gupta presentó su proyecto de interpretación de lenguaje de señas hace dos años, cuando aún era estudiante. “Creé este modelo usando una API de detección de objetos de TensorFlow. El modelo traduce algunas señas de ASL al inglés mediante aprendizaje por transferencia del modelo preentrenado ssd_mobilenet”, explicó en su publicación.

En una entrevista con Interesting Engineering, Gupta compartió que la idea surgió tras un comentario de su madre, quien un día le dijo que debía crear algo significativo mientras estudiaba ingeniería.

“Me lo dijo en tono de broma, pero me hizo reflexionar sobre cómo aplicar mis conocimientos y habilidades. Luego, un día, mientras conversaba con Alexa, se me ocurrió la idea de desarrollar una tecnología inclusiva. Ese fue el inicio de una serie de planes”, explicó.

Cómo es la IA que entiende lenguaje de señas

En febrero de 2022, Priyanjali Gupta, una joven desarrolladora en India, presentó un modelo de inteligencia artificial diseñado para interpretar el lenguaje de señas estadounidense (ASL).

La iniciativa, que surgió un año después de una conversación con su madre, utiliza la API de detección de objetos de Tensorflow y emplea un enfoque de aprendizaje por transferencia mediante el modelo ssd_mobilenet, previamente entrenado.

La publicación de Gupta en LinkedIn rápidamente se volvió viral, acumulando más de 66.000 reacciones y comentarios de más de 1.400 personas que valoraron su esfuerzo.

Gupta detalla en Github el proceso de construcción de su modelo. Explica que creó manualmente el conjunto de datos necesario para entrenar la inteligencia artificial, utilizando un archivo de Python que recolecta imágenes a través de su cámara web. Estas imágenes corresponden a señas en ASL para palabras y frases básicas como “hola”, “te amo”, “gracias”, “por favor”, “sí” y “no”.

La joven admitió que desarrollar la inteligencia artificial fue un proceso complejo a pesar de que añadió pocas señas. (GitHub)

Gupta admite que desarrollar un modelo de aprendizaje profundo especializado en la detección de señas es una tarea compleja. “Crear una red neuronal profunda únicamente para la detección de señales es bastante complicado”, comentó en una entrevista con le medio mencionado.

En su publicación de LinkedIn, varias personas la felicitaron por su trabajo y la alentaron a seguir. Respondió varios de ellos agradecida indicando que en ese momento “solo era una estudiante”.

“Sigue avanzando. Lo estás haciendo muy bien”, le comentó una persona. Gupta le respondió “¡Ni siquiera puedes imaginar cuánto me animaron tus palabras! ¡Muchas gracias!”.

Guantes que entienden lenguaje de señas

Al igual que Priyanjali Gupta en la universidad, Navid Azodi y Thomas Pryor quienes fueron estudiantes de la Universidad de Washington desarrollaron un par de guantes equipados con sensores, capaces de traducir el lenguaje de señas en inglés al conectarse a una computadora.

Dos estudiantes de la Universidad de Washington desarrollaron estos guantes capaces de interpretar lenguaje de señas en tiempo real. (YouTube: Lemelson MIT)

Estos guantes, llamados SignAloud, están equipados con sensores avanzados que detectan los movimientos y posiciones de las manos del usuario.

Los sensores recopilan datos específicos sobre la orientación y posición de las manos, así como los movimientos exactos que se realizan al gesticular en lenguaje de señas.

Esta información se envía de manera inalámbrica a una computadora, que utiliza algoritmos de aprendizaje automático para traducir los gestos en texto o, incluso, en tiempo real. El sistema es capaz de reconocer una gran variedad de gestos y combinaciones, lo que permite una traducción precisa y fluida.

Estos guantes se pueden usar, por ejemplo, en el ámbito educativo. Un estudiante sordo podría usar estos guantes para participar de forma activa en clases y discusiones, traduciendo sus señas en tiempo real, facilitando así la comunicación con sus compañeros y profesores.

infobae.com